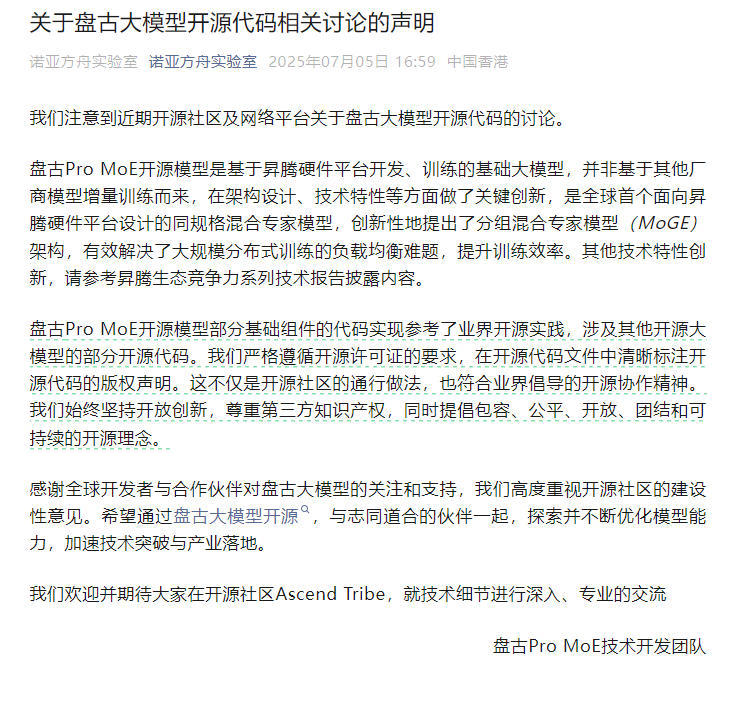

7月7日,针对近期网络上关于华为盘古大模型开源代码的讨论与质疑,盘古Pro MoE技术开发团队发布声明,对相关问题进行说明。

声明指出,盘古Pro MoE开源模型是基于华为昇腾(Ascend)硬件平台自主研发和训练的基础大模型,并非基于其他厂商模型的增量训练成果。华为强调,该模型在架构设计和技术特性上具有显著创新。

在技术层面,华为特别介绍了其提出的分组混合专家模型(MoGE)架构。据称,这是全球首个针对昇腾硬件平台设计的同规格混合专家模型。该架构通过优化大规模分布式训练中的负载均衡问题,显著提升了训练效率。更多技术细节可参考昇腾生态竞争力系列技术报告。

对于代码相似性争议,华为并未回避。声明承认,盘古Pro MoE的部分基础组件代码参考了业界开源实践,并涉及其他开源大模型的部分代码。但团队强调,这一做法完全遵循开源许可证要求,并在相关代码文件中明确标注了版权声明,符合开源社区的通行规范和协作精神。

华为重申了其在开源领域的立场,表示将坚持开放创新并尊重第三方知识产权。团队欢迎开发者与合作伙伴在官方开源社区Ascend Tribe中深入交流,共同推动模型优化与技术落地。