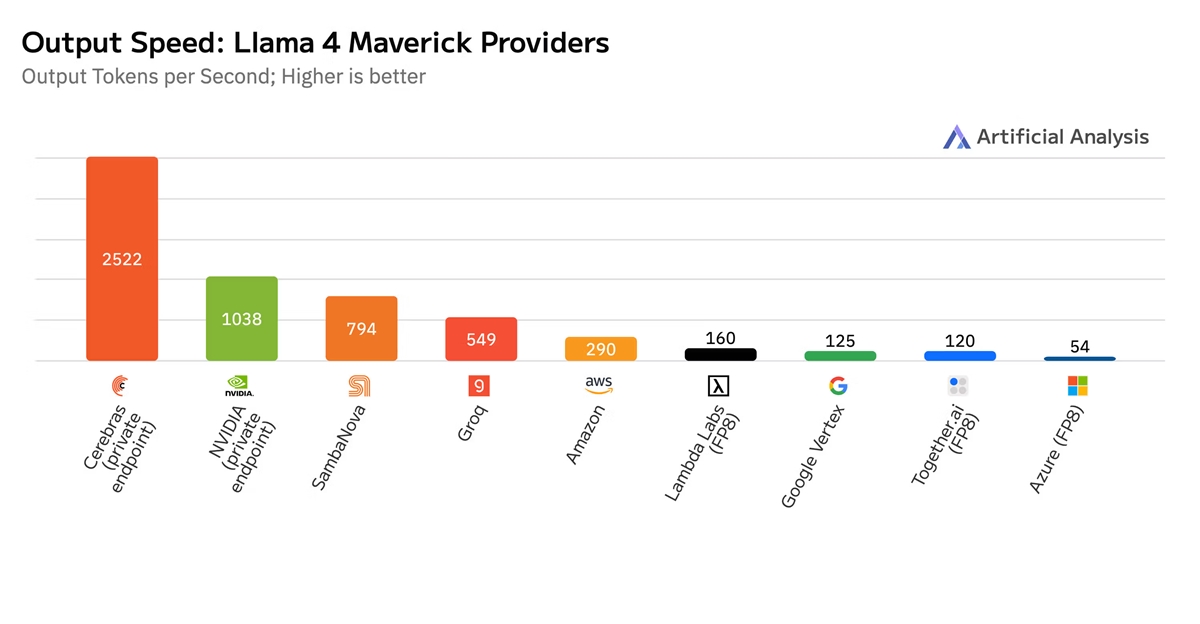

据Cerebras Systems官方宣布,基于其CS-3系统的云服务在400B参数的Llama 4 Maverick模型上创造了LLM推理速度的世界纪录,达到每秒2500个Token。这一速度是英伟达DGX B200系统的2.5倍,后者包含8个Blackwell GPU。该记录由基准测试公司Artificial Analysis测得。

Cerebras的CS-3系统搭载第三代晶圆级AI芯片WSE-3,采用台积电5nm制程,芯片面积达46225平方毫米,晶体管数量高达4万亿个。其AI核心数量为90万个,片上SRAM容量为44GB,整体内存带宽为21PB/s,结构带宽高达214PB/s。WSE-3的峰值性能为125 FP16 PetaFLOPS,相较上一代WSE-2提升了1倍。

Artificial Analysis的联合创始人兼首席执行官Micah Hill-Smith表示:“Cerebras已经打破了英伟达上周创下的Llama 4 Maverick推理速度记录。” 测试结果显示,Cerebras的Llama 4 Maverick端点每秒可处理2522个Token,而英伟达Blackwell仅为1038个Token。在多个供应商的测试中,Cerebras是唯一在Meta旗舰模型中优于Blackwell的推理解决方案。

此外,Artificial Analysis还测试了其他模型供应商的表现:SambaNova为794 Token/秒,亚马逊为290 Token/秒,Groq为549 Token/秒,谷歌为125 Token/秒,微软Azure为54 Token/秒。

Cerebras Systems首席执行官Andrew Feldman指出,当前企业部署的关键AI应用,如代理、代码生成和复杂推理,都受到推理延迟的瓶颈限制。Cerebras通过优化推理性能,使生成速度超过2500 Token/用户,远超GPU的低速表现。Cerebras的硬件和API服务在无需特殊优化的情况下实现了这一突破性性能,且即将通过Meta的API服务向公众开放。